Il lavoro sporco dei moderatori di contenuti

di Aura Fico

“L’obiettivo giornaliero è di 25 mila immagini ogni giorno. Devo arrivare a 25.000 immagini. Faccio questo lavoro da sei anni, potrei entrare nel Guinness dei primati”, racconta davanti alla telecamera uno dei testimoni intervistati in The Cleaners, documentario del 2018 che racconta la vita nascosta dei moderatori dei contenuti online.

Ogni minuto 2,5 milioni di post vengono pubblicati su Facebook. Ognuno di essi viene passato al vaglio da un algoritmo, fatto ad hoc da un programmatore, in modo che sia concordante con ciò che ci interessa e ci piace. A volte capita che sulle nostre homepage appaia qualcosa che non ci piace o che ci disturba, un video violento o un’immagine fastidiosa. La soluzione? Si preme il tasto “segnala” e l’algoritmo si mette a lavoro, cercando di identificare l’elemento “scomodo” e procedere ad eliminarlo se necessario.

La cosa che non molti sanno è che dietro a queste decisioni c’è un moderatore di contenuti in carne ed ossa, probabilmente sottopagato. La funzione dei moderatori di contenuti è necessaria perché ancora non esiste una soluzione esclusivamente tecnologica. Il loro lavoro serve proprio quando l’algoritmo si dimostra essere macchina, e non umano. Per il sistema ogni interazione con un contenuto è sinonimo di “approvazione”. Non comprende ironia o scherno, se l’algoritmo rileva molte interazioni con qualcosa, non farà altro che spalmarlo su più homepage possibili, in modo che tutti lo vedano.

Eventi del genere risultano problematici quando i contenuti in questione sono video o immagini che ritraggono scene violente. Nel 2017 lo stupro di una ragazza di quindici anni è stato mostrato live su Facebook per un lasso di tempo abbastanza lungo da far sì che quaranta persone riuscissero a vederlo. L’algoritmo non era riuscito a riconoscerne la pericolosità perché nel video non erano presenti elementi espliciti che potesse individuare come dannosi. Il contenuto è rimasto online finché non è finito sullo schermo di un moderatore che ha provveduto ad eliminarlo.

Non potendo inserire una censura preventiva, tutti i social network si appoggiano a questo doppio controllo, prima tecnologico, poi umano. Ogni errore nella catena di controllo può portare alla diffusione di contenuti disturbanti, informazioni false o immagini private. L’obiettivo principale dei moderatori di contenuti è quello di mantenere l’ordine in un’arena pubblica che conta più di due miliardi di utenti. Il loro è un lavoro di grande responsabilità, soprattutto se si considera che grazie a queste figure, le nostre “echo chambers”, bolle di contenuti create apposta per noi, crescono sempre di più, facendo aumentare in maniera sostanziosa gli utenti attivi.

Una piattaforma come Facebook conta 2,9 miliardi di profili attivi che si traducono in una fila interminabile di contenuti da controllare, per evitare che si diffondano le fake news e tutti quegli altri contenuti che vanno contro le linee guida del social network e dell’umanità stessa. Il loro ruolo è molto importante perché fungono un po’ da spazzini del web, tenendo le nostre homepage pulite e accattivanti, requisito fondamentale per tutte le aziende che investono in spazi pubblicitari su Internet. Detto così, sembrerebbe un lavoro normale, che promette una crescita personale e il raggiungimento di obiettivi personali, svolto in una delle aziende che fattura di più al mondo -solo nel 2022 Meta ha fatturato 116,61 miliardi di dollari-. Il sogno si è infranto quando qualche ex moderatore di contenuti ha deciso di parlare del proprio lavoro, portando alla creazione di articoli d’inchiesta e documentari, svelando i segreti dietro allo scintillante mondo di internet.

Un lavoro invisibile

La professione del moderatore di contenuti è pressoché invisibile. Uno dei primi campanelli d’allarme è proprio la difficoltà che si ha nel trovare delle informazioni a riguardo. Le stesse offerte di lavoro hanno titoli come “social media analyst” o “legal removals associate” e sono sponsorizzate da aziende terze. Attraverso una pratica di outsourcing, i social network si rendono liberi da ogni responsabilità, passando come una mano santa che fornisce posti di lavoro e opportunità.

Dalla ricerca del lavoro fino al primo colloquio, i candidati non hanno una reale idea delle mansioni che si dovranno svolgere, né della paga che riceveranno. Appena arrivati, i futuri moderatori di contenuti seguono un corso di formazione di un mese per quattro ore al giorno. Durante questi incontri vengono spiegate le linee guida a cui dovranno attenersi e successivamente viene mostrata qualche esempio di immagini che potrebbero riscontrare durante i turni di lavoro. In base alle immagini mostrate, gli aspiranti moderatori hanno trenta secondi per decidere cosa farne, attraverso due diverse icone: ignora o elimina. Sia durante la fase preparatoria, sia una volta assunti, i moderatori devono mantenere una percentuale di successo fissata dalle aziende, che è del 98%, stringendo sempre di più il margine di errore fino a farlo arrivare a tre errori al mese per ognuno di loro. Una stima che non tiene conto della realtà dei fatti e soprattutto della mole e del tipo di immagini a cui sono sottoposte queste persone.

Se dopo un mese si è ancora convinti di voler procedere, lo step successivo è la firma di un “non-disclosure agreement” che impedisce di parlare del proprio lavoro con chiunque, dai propri colleghi alla propria famiglia, creando un senso di forte isolamento. Dietro alla necessità fittizia di proteggere i dati degli utenti e l’incolumità stessa dei moderatori, questi contratti vengono fatti firmare prevenendo l’intervento di qualche ficcanaso, rendendo questa professione sempre più oscura e poco regolamentata. Ufficialmente i lavoratori a intermittenza della “gig economy” a cui si affida Facebook sono più di 15.000, sparsi in tutto il mondo, in modo da coprire più contenuti possibili.

Alcune testimonianze raccolte da Casey Newton in “The Trauma Floor” raccontano la realtà di questa professione negli Stati Uniti. I dipendenti della Cognizant raccontano che è proibito portare in ufficio materiale per scrivere, fogli o pezzi di carta e il proprio smartphone. Qualunque altro oggetto deve essere posto all’interno di una busta trasparente, proprio come in aeroporto.

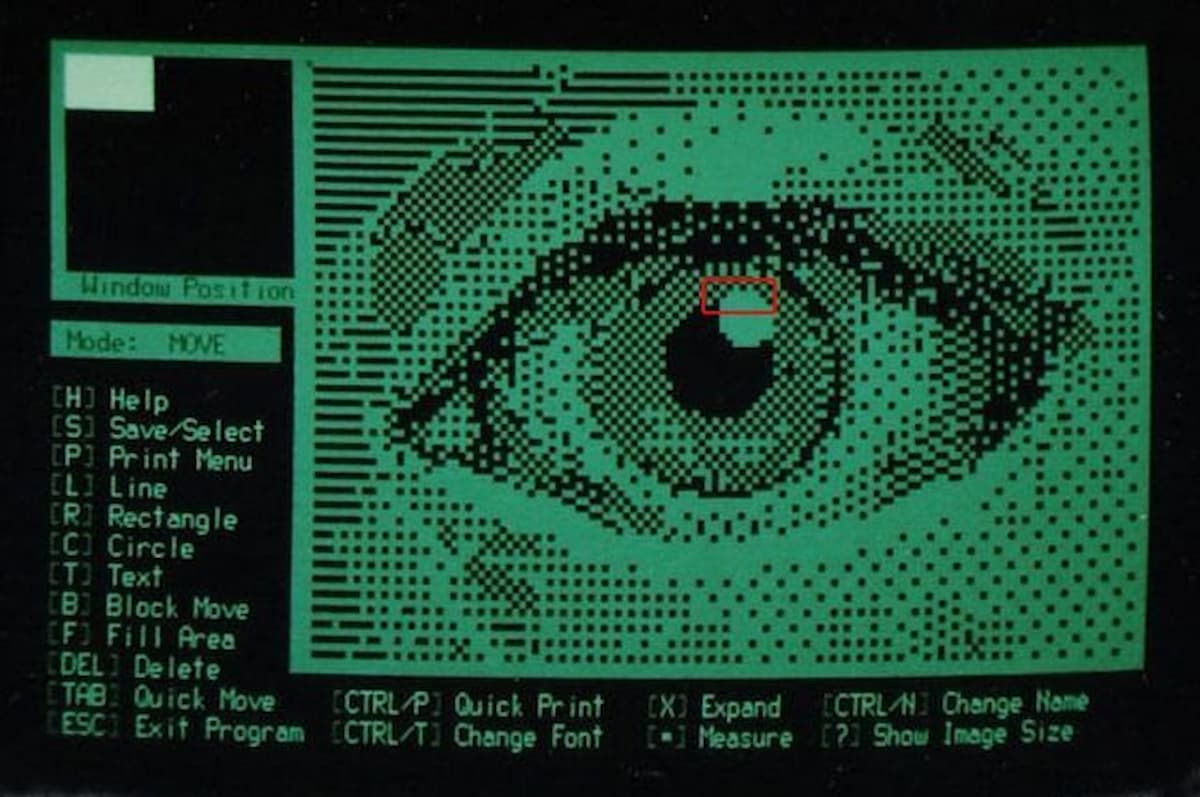

La condizione lavorativa in ufficio può sembrare, almeno all’apparenza, quella di una qualunque compagnia che si occupa di fornire servizi online, una serie di scrivanie e computer. Ogni postazione è divisa dall’altra attraverso un separatore di plastica opaca, gli schermi hanno tutti colori tenui e luminosità basse. Seduti uno accanto all’altro i moderatori passano dalle 8 alle 10 ore davanti a uno schermo, visionando continuamente immagini di uccisioni, violenze sessuali, video di pestaggi e molto altro, un po’ come la scena di Arancia Meccanica.

Ogni dipendente ha a disposizione due pause al giorno, oltre ai 30 minuti per pranzare, che durano intorno ai 15 minuti e devono essere segnalate attraverso un’estensione del browser. Nel momento in cui viene cliccata, parte un conto alla rovescia. Nel caso in cui allo scadere del tempo la scrivania fosse ancora vuota il dipendente perderà punti sul suo lavoro. Negli uffici statunitensi, i dipendenti hanno a disposizione 9 minuti al giorno per scaricare la tensione. Molti confermano di utilizzare queste pause per andare in bagno, mentre altri le usano per pregare, anche se vengono interrotti allo scadere esatto del tempo per tornare a lavoro.

Mentre il resto del mondo considera una settimana lavorativa di 4 giorni, professioni come quella dei moderatori di contenuti ricevono una paga irrisoria se si guarda al carico di stress a cui sono sottoposti. Se un dipendente medio di Facebook guadagna 240.000 dollari all’anno, comprendendo bonus e azioni in borsa, un moderatore situato nello stesso paese ne guadagna 28,800.

Contemporaneamente dall’altra parte del mondo, altre migliaia di persone si trovano a fare lo stesso lavoro in condizioni ben peggiori. Il documentario “The Cleaners” di Moritz Riesewieck e Hans Block raccoglie le voci dei moderatori che si trovano nelle Filippine, uno dei paesi in cui si trovano le aziende terze a cui si appoggia Facebook.

Alla domanda “Perchè fai questo lavoro” la risposta prende due strade diverse. La prima è quella che segue le necessità economiche di un paese in cui il divario tra ricchezza e povertà è ancora enorme. Infatti, spesso la scelta per i dipendenti che si trovano nelle Filippine è tra fare il moderatore di contenuti in un ufficio di piccole dimensioni, oppure raccogliere la spazzatura per le strade della città.

La seconda strada è quella che tocca non solo le necessità economiche, ma anche quelle ideologiche.

Le Filippine sono uno dei paesi con la percentuale più alta di cristiani cattolici praticanti, la religione guida le vite dei credenti anche nelle scelte quotidiane. Nella professione di moderatore di contenuti viene vista, oltre a un’entrata economica più alta rispetto ad altre professioni, la possibilità di perseguire un obiettivo più grande, come ammette una delle persone coinvolte:

“Come moderatore di contenuti devi avere dei principi solidi. Decidi se la gente debba vedere o meno un’immagine, quindi il primo errore grave è approvare una foto di nudo, seni femminili o genitali maschili. Sono del tutto inaccettabili”

Questa forte influenza religiosa porta tutta una serie di conseguenze sui contenuti che vengono moderati e in certi casi censurati, come ad esempio i contenuti di altre religioni. La censura di contenuti di stampo religioso è stato uno dei punti su cui Facebook ha dovuto dare delle spiegazioni durante un’investigazione delle Nazioni Unite. L’azienda è stata accusata di aver avuto un ruolo sostanziale nel genocidio della comunità Rohingya in Myanmar, essendo stato l’unico mezzo di informazione durante la transizione democratica del paese. Nel 2017 sono stati trovati più di 150 gruppi attivi sulla piattaforma che portavano avanti messaggi d’odio e atti razzisti nei confronti della minoranza religiosa dei Rohingya, tutt’oggi non riconosciuta nel paese. Dopo varie sollecitazioni l’azienda ha messo a disposizione il progetto “Honey Badger” un gruppo di 60 moderatori che si sarebbero occupati dei 18 milioni di utenti attivi nel paese. Nonostante le precauzioni perse, questo non è bastato a fermare le violenze contro la comunità. La diffusione di alcune fake news portò infatti alla morte di due persone della comunità Rohingya, accusate di stupro e solo dopo la loro morte, dichiarate innocenti.

Invisibili sì, ma traumatizzati

“Il lavoro danneggia il tuo cervello facendoti pensare che la violenza sia normale. Che uccidere gli altri o bombardare sia normale”

Durante il processo di selezione del personale non vengono richieste particolari capacità e non si effettuano test attitudinali o di altro tipo. Questo implica che anche chi soffre di disturbi d’ansia o del comportamento, può essere assunto e trovarsi a guardare per molte ore video che disturberebbero chiunque, mettendo in grave pericolo la propria salute mentale. Nei casi di tentato suicidio online, i moderatori sono tenuti a segnalarli immediatamente alle autorità competenti, senza poi sapere più nulla sulla persona che hanno visto minacciare di togliersi la vita. Ritrovandosi come dei supereroi che, in assenza di feedback, non riescono a vedere i risultati del proprio lavoro. Ad aggiungersi alle cause dello stress psicologico c’è anche la mancanza di input esterni. L’impossibilità di parlare del proprio lavoro porta queste persone a chiudersi in sé stesse, rendendo i rapporti sociali un limite più che uno stimolo. Inoltre, uno stipendio base di un moderatore non permette di poter frequentare altri tipi di attività che potrebbero alleviare, anche per poco, la pressione che si portano addosso. I pochi supporti psicologici messi a disposizione dall’azienda sono, a detta dei dipendenti stessi, insufficienti.

Dopo vari episodi di crolli mentali e diagnosi di stress post traumatico, qualcuno ha alzato la testa e ha deciso di denunciare, come nel caso di Sean Burke.

“Durante il mio primo giorno di lavoro, uno dei primi contenuti che ho dovuto controllare era un video dove una persona veniva picchiata a morte con un pezzo di legno con dei chiodi. Solo un’ora dopo ho visto per la prima volta in vita mia dei contenuti pedopornografici. Ti trovi a guardare il peggio che l’umanità ha da offrire e ne sei completamente scoraggiato”.

Burke ha chiesto aiuto dopo essersi accorto che la propria condizione psicologica stava peggiorando velocemente. Un dottore gli ha prescritto dei farmaci per l’ansia e il suo punteggio a lavoro è diminuito, come risposta il suo contratto non è stato esteso, ritrovandosi senza lavoro e con forti traumi.

All’interno del DSM-5, ovvero il Manuale diagnostico e statistico dei disturbi mentali, caposaldo dei manuali di psicologia, lo stress dei moderatori dei contenuti è descritto come “trauma secondario”, di cui sono solitamente vittime dottori o fornitori di primo soccorso. Il punto è che a queste figure professionali viene fornito un accurato supporto psicologico, mentre i moderatori non ne ricevono affatto.

Dopo tutte le testimonianze raccolte e le indagini svolte, il lavoro di moderatore di contenuti resta comunque un’ottima esca per chi pensa di poter trovare una professione facile che permetta di gestire il proprio tempo. Ancora oggi tantissimi utenti dei social network non hanno idea che dietro alle proprie segnalazioni ci siano degli umani in carne ed ossa, costretti a sorbirsi tutto il marcio della società affinché gli altri non possano vederlo. La strada per una soluzione tutta automatizzata è ancora lontana e il lavoro dei moderatori di contenuti risulterà necessario fino a quel momento. Se insieme allo sforzo di creare un algoritmo sempre più intelligente che riesca a sostituire queste figure, ci fosse un supporto reale e concreto, non diventeremmo solo una società ancora più connessa ma anche più umana.